AGENCE SEO GEO À MADAGASCAR – EXPERTS EN VISIBILITÉ ORGANIQUE

QU’EST-CE QU’UNE AGENCE SEO ET POURQUOI FAIRE DU SEO?

Une agence SEO est une agence de marketing numérique spécialisée en référencement naturel, mais également en GEO (Generative Engine Optimisation).

Son objectif principal est de positionner ses clients en haut des résultats des moteurs de recherche comme Google sur des termes spécifiques. Le SEO, ou référencement naturel, est une technique de marketing numérique particulièrement efficace. En effet, près de la moitié des entreprises déclarent que le SEO leur apporte le meilleur retour sur investissement.

La Generative Engine Optimisation (GEO) est une approche avancée du référencement naturel (SEO) qui va au-delà des techniques traditionnelles pour optimiser la visibilité en ligne d’un site web. Contrairement au SEO classique, qui se concentre principalement sur l’optimisation des mots-clés, de la structure du site et de la qualité des liens entrants, la GEO intègre des technologies et des algorithmes avancés pour générer du contenu de manière dynamique et personnalisée en fonction des comportements des utilisateurs, des données géographiques et d’autres variables contextuelles.

Pour positionner les sites internet de ses clients, une agence SEO met en œuvre un ensemble de techniques telles que l’audit SEO, la rédaction Web, l’optimisation technique et l’acquisition de liens. Ces méthodes contribuent à propulser votre site Web en tête des résultats de recherche sur Google.

Si vous recherchez une agence de référencement naturel, sachez qu’Orion Digital a mis en place des centaines de stratégies SEO et GEO. Notre compagnie est reconnue parmi les meilleures agences SEO à Montréal. Quel que soit votre secteur d’activité et vos objectifs d’affaires, nos experts SEO et GEO sont en mesure de développer la stratégie d’acquisition de trafic et de leads dont votre entreprise a besoin.

Contactez notre agence dès maintenant pour recevoir une offre de service sur-mesure pour votre entreprise!

LES SERVICES DE NOTRE AGENCE SEO À ANTANANARIVO, MADAGASCAR

Le SEO représente une composante essentielle de toute stratégie de marketing web, généralement responsable de plus de 70% du trafic d’un site web. Pour garantir des résultats optimaux, notre agence SEO s’engage à optimiser toutes les composantes influençant votre positionnement sur Google.

Stratégie SEO

La conception de votre site web, votre secteur d’activité, vos concurrents, les mots-clés ciblés, les médias qui mentionnent votre entreprise et votre positionnement actuel déterminent la stratégie de référencement naturel à adopter. Notre équipe élabore une stratégie SEO sur mesure, agissant comme un plan d’action visant à propulser votre présence en ligne vers de nouveaux sommets.

Audit SEO

Chaque projet SEO commence par une analyse exhaustive de votre site web, également appelée audit SEO. Cette étape permet d’évaluer vos positions actuelles sur les mots-clés cibles par rapport à vos concurrents, ainsi que les aspects techniques qui pourraient affecter l’indexation de vos pages web. L’audit SEO est indispensable pour élaborer un plan d’action adapté à votre site web.

Étude de mots-clés

L’étude de mots-clés est la première étape cruciale d’une stratégie SEO réussie. Elle consiste à identifier les termes les plus recherchés par votre audience et ceux susceptibles de générer des conversions. Nos experts en SEO utilisent des outils avancés pour effectuer des recherches de mots-clés efficaces, distinguant ceux qui génèrent du trafic de ceux qui génèrent des ventes.

Rédaction Web

La rédaction de contenu optimisé est essentielle pour améliorer la visibilité et la notoriété de votre entreprise dans les résultats de recherche. Nos consultants SEO élaborent des stratégies de contenu efficaces, conçues pour améliorer vos positions dans les résultats de recherche tout en incitant les visiteurs à convertir.

Acquisition de liens (backlinks)

Pour renforcer le référencement de votre site, il est crucial d’obtenir des liens de qualité provenant de sites réputés. Notre équipe de spécialistes SEO travaille quotidiennement avec une vaste gamme de sites web au Madagascar et à l’international pour vous fournir des liens à forte autorité, renforçant ainsi votre autorité de domaine et votre positionnement dans les résultats de recherche.

Stratégie de référencement local

Si vous visez un public local spécifique à Antananarivo, Madagascar, le référencement local est essentiel. Nos experts en SEO local mettent en œuvre des stratégies spécifiques pour améliorer votre visibilité sur Google Maps et Google My Business, maximisant ainsi l’impact de vos actions et assurant un retour sur investissement optimal pour votre entreprise. Confiez votre projet de référencement web à des spécialistes qui maîtrisent les subtilités du SEO local.

EST-CE QUE LE SEO EST ADAPTÉ À VOTRE ENTREPRISE?

Vos clients recherchent-ils vos produits ou services sur Google?

Lorsque vos clients potentiels recherchent des produits ou services similaires aux vôtres sur Google, être présent lors de cette recherche initiale est crucial. En effet, la majorité des utilisateurs ne sont pas nécessairement attachés à une marque spécifique au départ et se fient aux résultats affichés en première page. Notre agence SEO à Montréal peut vous aider à améliorer votre visibilité en ligne et à capturer cette audience qualifiée lors de leurs recherches initiales

Vos concurrents se positionnent-ils devant vous sur Google?

Si vos concurrents sont mieux positionnés que vous dans les résultats de recherche, vous pourriez perdre une part importante du trafic potentiel. Les quatre premiers résultats organiques captent la majorité du trafic, ce qui souligne l’importance d’occuper une place de choix dans les résultats de recherche. Notre agence de référencement naturel à Montréal maîtrise les critères utilisés par Google pour déterminer les classements, et nous pouvons vous aider à rivaliser avec vos concurrents.

Vous souhaitez augmenter le trafic vers votre site Web?

Le référencement naturel génère une part significative du trafic web total au Canada, offrant ainsi une opportunité importante d’attirer des visiteurs qualifiés sur votre site. Confier votre stratégie SEO à notre agence spécialisée vous permettra de bénéficier de ces avantages et d’observer une augmentation du trafic vers votre site.

Vous cherchez à renforcer votre notoriété?

Apparaître en haut des résultats de recherche de Google renforce la crédibilité de votre entreprise aux yeux des utilisateurs. Vous constaterez que nous sommes un cordonnier bien chausse. Les internautes ont tendance à accorder plus de confiance aux résultats naturels, ce qui peut aider à renforcer votre réputation et votre autorité dans votre domaine. Notre agence SEO basée à Antananarivo vous accompagnera dans toutes les étapes pour devenir une référence dans votre secteur et garantir une présence en ligne optimale pour votre entreprise.

Comment Réaliser un Audit Sémantique SEO Infaillible : Le Guide

⏲ Vous rêvez de voir votre site web en haut des résultats Google ? Vous savez qu’un audit sémantique SEO est incontournable pour votre référencement

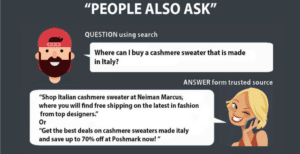

Comment utiliser People Also Ask pour réussir votre référencement naturel

Lancée en 2015, la fonctionnalité « People Also Ask » de Google donne aux utilisateurs la capacité d’identifier d’autres demandes liées à leur sujet. Depuis le début,

Survivrez-vous a IA générative Magi(e) de Google en 2024 et la SGE

Découvrez la révolution de la recherche en ligne avec la Search Generative Experience (SGE) de Google. Annoncée lors de la dernière Google I/O, la SGE

Le SEO et le SEA : Les Piliers de l’Écosystème Digital Moderne

Dans l’univers complexe des moteurs de recherche, l’écosystème digital est façonné par trois acteurs clés qui interagissent pour influencer la manière dont nous naviguons sur

Que va devenir le référencement naturel avec les AI Génératives

Les innovations en matière d’intelligence artificielle générative bouleversent-elles le paysage du marketing digital ? Dans le domaine crucial du content marketing et du SEO, qui

Les Blogs WordPress Classiques Sont-ils Mortels ? 5 Raisons de Penser Oui

Les blogs WordPress classiques ont longtemps été la norme dans le monde du marketing de contenu. Cependant, avec l’évolution rapide des algorithmes des moteur de

Améliorer votre SEO grâce à la balise meta description

La balise meta description est l’extrait qui s’affiche sous les titres de contenu sur Google. Elle sert à décrire votre contenu en 4 lignes, soit

Comment améliorer la visibilité de votre chaine vidéo YouTube

Avec 2,5 milliards d’utilisateurs actifs mensuels, YouTube est l’un des sites web les plus populaires de l’internet aujourd’hui depuis son rachat par Google en 2006.

Référencement local : Importance pour les entreprises depuis Covid!9

Le référencement local ou pack local SEO ou référencement local google a pris beaucoup d’importance avec la crise du covid-19 en raison du confinement covid19 et

Comment optimiser la stratégie SEO aux recherches vocales ?

Au fil du temps, les gens ont utilisé divers types de technologies pour effectuer leurs recherches en ligne. Un type de technologie récemment devenu populaire

Google Webmaster essential est mort, vive Search Essential

Vous avez entendu parler des consignes aux webmasters de Google ? Elles existent depuis des années et expliquent les choses à faire et à ne

Comment optimiser son maillage interne pour completer votre link building Seo ?

Pourquoi parle-t-on de conception de site et de liens internes, alors que je pourrais juste travailler mon Netlinking SEO basique ou Link building Seo et